MCP, el protocolo universal que conecta la IA con datos y herramientas

¿Qué es MCP y por qué surge?

El Protocolo de Contexto de Modelo (Model Context Protocol, MCP por sus siglas en inglés) es un estándar abierto creado para conectar asistentes de IA con las fuentes de datos y herramientas que contienen el contexto que necesitan.

Nació a finales de 2024 de la mano de Anthropic como respuesta a un problema creciente: incluso los modelos de lenguaje más avanzados suelen estar aislados de los datos reales, atrapados detrás de silos de información y sistemas incompatibles. Cada nueva integración (por ejemplo, conectar un chatbot a una base de datos, o a un servicio corporativo) requería hasta entonces una solución a medida, lo que dificultaba escalar y mantener sistemas de IA realmente conectados.

MCP busca estandarizar estas conexiones de forma universal, sustituyendo integraciones fragmentadas por un único protocolo común. Anthropic lo ha comparado con un “puerto USB‑C para aplicaciones de IA”, ya que brinda una forma unificada de enchufar modelos de IA a diversas fuentes de datos y herramientas externas. En esencia, MCP facilita que un modelo (por ejemplo, un asistente tipo chat o un sistema de auto-completar código) pueda obtener información actualizada, relevante y específica desde los sistemas donde reside (archivos, bases de datos, APIs, etc.), mejorando así la calidad y pertinencia de sus respuestas.

Arquitectura técnica: ¿Cómo funciona MCP?

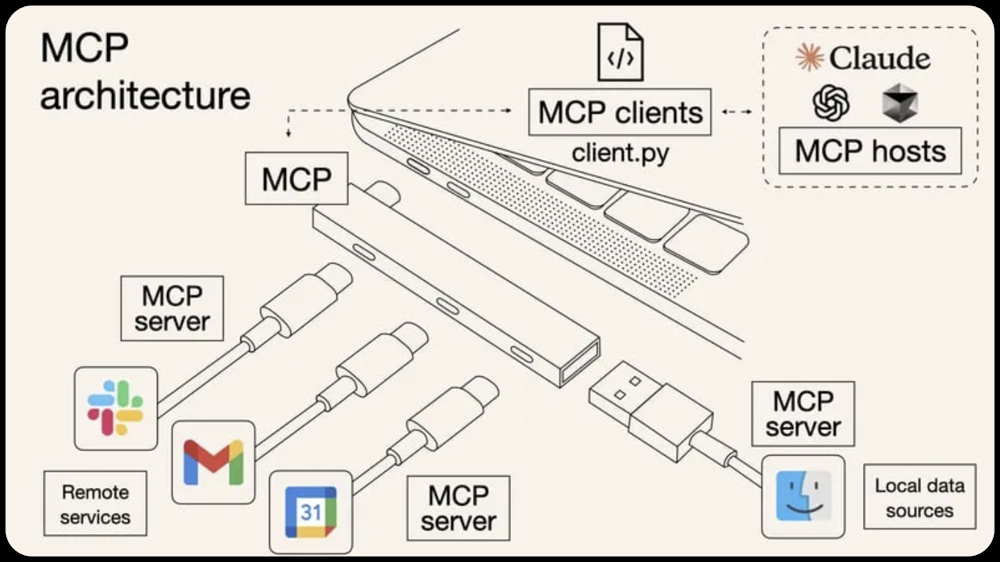

MCP sigue una arquitectura cliente-servidor modular. En esta arquitectura intervienen tres roles principales:

- Host MCP – la aplicación de IA o entorno donde corre el modelo (por ejemplo, Claude Desktop, un IDE de programación con asistente de código, u otras herramientas de IA). El host es quien inicia la conexión para acceder a datos mediante MCP.

- Cliente MCP – es el componente dentro del host que se encarga de la comunicación con los servidores. Cada cliente mantiene una conexión 1:1 con un servidor MCP específico. En la práctica suele ser una librería (SDK) integrada en la app de IA que habla el protocolo MCP.

- Servidor MCP – es un programa ligero que expone una fuente de datos o servicio externo a través del protocolo MCP. Un servidor MCP actúa como adaptador: conecta con una fuente (un sistema de ficheros local, una API web, una base de datos, etc.) y la presenta de forma estandarizada al cliente MCP.

Estos elementos permiten conexiones de muchos a muchos: un host puede conectarse a múltiples servidores MCP a la vez, y a su vez un mismo servidor MCP podría ser consultado por distintos hosts o aplicaciones, siempre mediante clientes MCP adecuados. Los servidores MCP pueden acceder tanto a datos locales (por ejemplo archivos del ordenador, servicios internos) como a servicios remotos vía red (APIs web, plataformas cloud), siempre aplicando controles de seguridad y permisos que configure el desarrollador.

Representación conceptual de la arquitectura MCP a modo de hub USB. Los hosts (p. ej. asistentes como Claude o entornos IDE) se conectan mediante un cliente MCP (librería, ilustrado como client.py) a múltiples servidores MCP, que a su vez “enchufan” diversas fuentes de datos. En este esquema, los rectángulos con logos (Slack, Gmail, Calendar) representan servicios remotos expuestos a través de servidores MCP, mientras que el conector con el icono de una carpeta (Finder) representa un datos locales accesibles por otro servidor MCP. MCP actúa como el puerto común que estandariza la comunicación entre los modelos de IA (hosts) y las herramientas externas (servers), evitando tener que crear integraciones ad-hoc para cada herramienta.

Primitivas del protocolo: Recursos, Herramientas y Prompts

La especificación de MCP define varias primitivas o tipos de interacción estándar entre clientes y servidores. Las tres más importantes son Recursos (Resources), Herramientas (Tools) y Prompts, las cuales permiten cubrir distintos casos de uso de intercambio de información:

- Recursos: representan datos o contenido estático que un servidor MCP pone a disposición del cliente. Pueden ser desde el contenido de un archivo, registros de una base de datos, resultados de una API, hasta una imagen o un log de sistema. Cada recurso se identifica con un URI (por ejemplo, file://ruta/al/archivo.txt o postgres://servidor/consulta) y puede ser de tipo texto o binario. Los recursos sirven para enriquecer el contexto del modelo – por ejemplo, proporcionando el texto de un documento relevante para que el asistente lo tenga en cuenta al responder. Cabe señalar que, en la mayoría de implementaciones actuales, el uso de recursos está controlado por la aplicación (no por el modelo en automático): típicamente el usuario o desarrollador debe indicar qué recursos quiere inyectar al contexto antes de que el modelo los use. Esto evita que el sistema acceda indiscriminadamente a datos sin supervisión; si se desea un acceso más autónomo por parte de la IA, MCP ofrece las Herramientas como alternativa (ver más abajo).

- Herramientas: permiten exponer funcionalidades ejecutables o acciones a través de MCP. Es decir, no solo datos estáticos, sino operaciones que el modelo puede pedir que se realicen, como realizar una búsqueda, consultar una API, ejecutar una consulta SQL o incluso controlar un dispositivo. Una herramienta en MCP se define con un nombre, una descripción y un esquema de parámetros de entrada, y el servidor MCP implementa la lógica de qué hacer cuando se invoca. Las herramientas están diseñadas para ser invocadas de forma controlada por el modelo (con la aprobación del usuario/humano en el bucle). En otras palabras, el asistente de IA puede decidir llamar a una herramienta durante su generación de respuesta (por ejemplo, “llamar a la herramienta de Búsqueda web con la pregunta X”), el cliente MCP envía esa solicitud al servidor correspondiente, el servidor ejecuta la acción (por ejemplo, hace la búsqueda en la web) y devuelve el resultado para que el modelo lo incorpore a su respuesta final. MCP estandariza este ciclo mediante endpoints genéricos de listado de herramientas disponibles y llamada a una herramienta específica. Un punto clave es que las herramientas pueden cambiar el estado o interactuar con el mundo real (a diferencia de los recursos que solo son lectura), por lo que su uso suele requerir confirmación y auditoría.

- Prompts: en MCP, un “prompt” hace referencia a plantillas de solicitud o instrucciones predefinidas que el servidor ofrece para uso del modelo o del usuario. Son básicamente prompt templates reutilizables que estandarizan interacciones comunes. Por ejemplo, un servidor MCP podría proveer un prompt llamado “Analizar código” que instruye al asistente a analizar un fragmento de código en busca de errores, posiblemente aceptando como argumento el lenguaje de programación. Los prompts pueden aceptar parámetros dinámicos, incluir contexto de algunos recursos automáticamente, encadenar múltiples interacciones (p. ej. pasos de una tarea) y servir como flujos de trabajo guiados. A diferencia de las herramientas, los prompts están pensados para ser iniciados por el usuario o la aplicación (son user-controlled): por ejemplo, podrían aparecer como opciones en la interfaz (un botón o un comando rápido) que el usuario selecciona para que el asistente ejecute esa plantilla de interacción. Esto brinda consistencia en tareas repetitivas y mejores prácticas a la hora de pedirle cosas al modelo.

Además de estos, MCP define otras construcciones, como Sampling (una forma de solicitar al servidor que el propio modelo genere texto, útil para ciertos agentes colaborativos), y Roots (puntos de entrada a recursos del sistema), entre otras. También estandariza el formato de los mensajes (basado en JSON-RPC 2.0) y puede funcionar sobre distintos transportes de red (HTTP, WebSockets, Server-Sent Events, etc.), manteniendo independencia de la capa física de comunicación.

En conjunto, la arquitectura MCP proporciona una “capa intermedia” (middleware) universal para que modelos de lenguaje y herramientas externas se comuniquen de forma estructurada. El desarrollador solo debe implementar un servidor MCP por cada sistema que quiera exponer, o usar alguno de los servidores ya disponibles, y cualquier modelo/herramienta compatible con MCP podrá conectarse siguiendo el mismo lenguaje común.

Ejemplo práctico de MCP en acción

Para ilustrar cómo se usa MCP en la práctica, imaginemos un par de escenarios concretos:

- Asistente de programación en un IDE: Supongamos que estamos usando un entorno de desarrollo integrado (IDE) con un asistente de código impulsado por IA. Sin MCP, este asistente estaría limitado al contexto del archivo abierto o a lo que uno le copie/pegue. Con MCP, el IDE puede conectar un servidor MCP de Git/GitHub: éste expone operaciones como buscar en el repositorio, obtener el contenido de un archivo o revisar el historial de commits. Así, cuando el desarrollador hace una pregunta (“¿Dónde se define la función X?”), el asistente puede invocar la herramienta correspondiente (por ejemplo, “buscar referencia de X en el repositorio”) y obtener la respuesta en tiempo real del servidor Git, incorporándola a su explicación. De hecho, varias herramientas de desarrollo ya están adoptando MCP para enriquecer sus asistentes: compañías como Zed, Replit, Codeium o Sourcegraph han trabajado con MCP para que sus plataformas permitan a los agentes de IA recuperar información de contexto relevante del código y producir código más ajustado con menos intentos.

- Agente de conocimiento empresarial (chatbot interno): Pensemos ahora en un asistente tipo chat dentro de una empresa, que deba consultar información de Slack y documentos de Google Drive para responder preguntas. Con MCP, es posible desplegar fácilmente un servidor MCP de Slack y un servidor MCP de Google Drive (de hecho, existen implementaciones abiertas de referencia para ambos). El servidor de Slack expondrá, por ejemplo, los canales y mensajes (con las debidas restricciones de acceso) permitiendo al asistente buscar mensajes relevantes o resumir conversaciones. El servidor de Google Drive hará lo propio con los archivos y carpetas, permitiendo búsquedas de texto y lectura de documentos. Todo ello de forma unificada: el asistente puede listar qué recursos ofrece Slack (canales, hilos) o qué herramientas tiene Drive (buscar archivos por nombre, por contenido, etc.), y utilizarlos según convenga. Por ejemplo: un usuario podría preguntarle al asistente “¿Qué se decidió en la última reunión sobre el proyecto X?” y el asistente, vía MCP, podría buscar en Slack el canal o hilo de la reunión correspondiente, obtener un resumen de los mensajes (recurso) y devolvérselo al usuario. Todo sin programación específica para Slack o Drive, ya que ambos cumplen el estándar MCP. De hecho, ya hay servidores MCP oficiales para Slack (gestión de canales y mensajes), Google Drive (acceso a ficheros y búsquedas), entre muchos otros sistemas populares, listos para usar.

El desarrollador o integrador no tiene que escribir código personalizado para cada API, sino simplemente conectar (o habilitar) el servidor MCP adecuado. El modelo de IA, por su parte, no necesita conocimiento preprogramado de cada sistema; interactúa con todos mediante las mismas operaciones genéricas de MCP (listar recursos, llamar herramientas, etc.). Así se logra que la IA mantenga el contexto relevante a medida que salta entre distintas fuentes de información, en lugar de quedarse “ciega” fuera de su entrenamiento fijo.

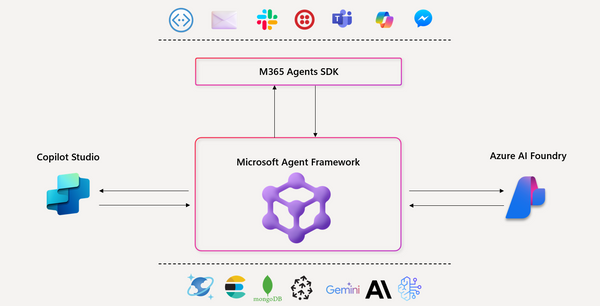

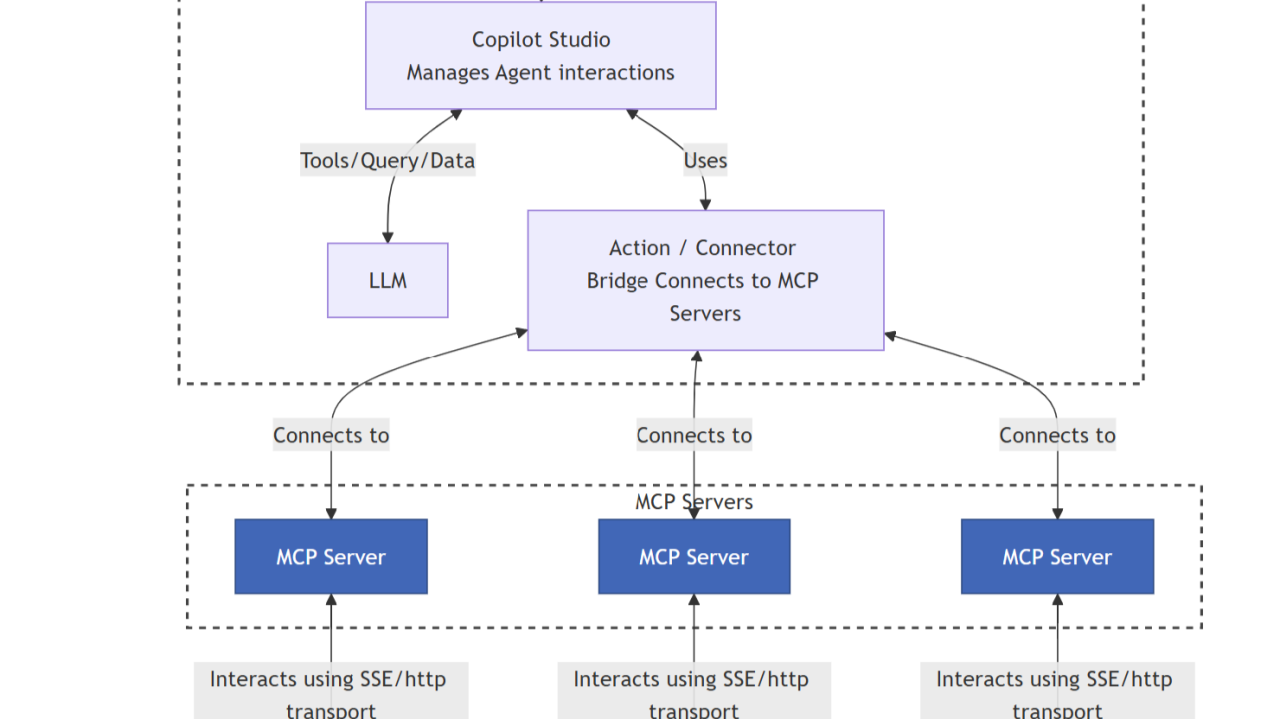

MCP desde Microsoft Copilot Studio

Una de las adopciones recientes de MCP es su integración en Microsoft Copilot Studio, la plataforma de Microsoft para crear y gestionar agentes de IA personalizados. En marzo de 2025, Microsoft anunció soporte nativo de MCP en Copilot Studio, lo que permite a los makers (desarrolladores o administradores) conectar servidores MCP a sus agentes con solo unos clics. En Copilot Studio, esto se traduce en que al editar un agente (por ejemplo, un asistente para Recursos Humanos), podemos añadir “acciones” basadas en MCP desde la interfaz. Basta con seleccionar “Add an action” y buscar el conector MCP deseado (ya sea uno personalizado o alguno de los disponibles en el marketplace). Por ejemplo, podríamos agregar una acción “Buscar respuesta en la base de conocimientos interna” conectando un servidor MCP que indexa la documentación corporativa. Una vez conectado, cada herramienta que exponga el servidor MCP aparecerá como una acción disponible en el agente – heredando automáticamente el nombre, descripción, entradas y salidas definidas por ese servidor. El creador del agente no tiene que redefinir nada manualmente; si mañana se agrega una nueva herramienta en el servidor MCP, aparecerá automáticamente para usarse en Copilot, y si se retira o modifica alguna, también se reflejará sin intervención. Esto reduce drásticamente el esfuerzo de mantenimiento, evitando errores por acciones desactualizadas.

Otro aspecto importante es que Copilot Studio integra estos servidores MCP a través de su infraestructura de conectores empresariales, lo que significa que respetan las políticas de seguridad y gobierno de datos corporativas. Por ejemplo, se pueden conectar con redes virtuales aisladas, aplicar controles de Prevención de Pérdida de Datos (DLP) y emplear métodos de autenticación robustos para acceder a sistemas internos. En la práctica, esto habilita acceso en tiempo real a datos para los agentes de Copilot, pero con las garantías de cumplimiento que las empresas requieren.

Copilot Studio + MCP permite a las empresas orquestar agentes de IA mucho más potentes sin lidiar con integraciones a medida: simplemente enchufando las fuentes de conocimiento que necesiten a través de servidores MCP. Microsoft destaca que esto proporciona flexibilidad (los agentes pueden ampliarse dinámicamente con nuevas capacidades) y acelera el desarrollo al reutilizar la creciente librería de conectores MCP disponibles.

MCP desde Azure AI Foundry

Otro entorno donde MCP está ganando terreno es Azure AI Foundry, la plataforma de Azure para construir, alojar y ejecutar aplicaciones de IA. En particular, el servicio Azure AI Agents dentro de Foundry –que permite crear y escalar agentes de IA con capacidad de conectar a múltiples fuentes– ahora soporta MCP de forma nativa.

¿Qué implica esto? Básicamente, Azure AI Foundry permite exponer sus agentes como servidores MCP. Un agente de Azure (que podría combinar varias habilidades, como realizar búsquedas con Bing, consultar datos de Azure Cognitive Search, leer archivos de SharePoint, etc.) se puede “publicar” vía MCP, de modo que cualquier cliente compatible pueda interactuar con él. Por ejemplo, Anthropic Claude Desktop es un cliente MCP compatible (como vimos antes), y Microsoft proporciona una guía de integración donde un agente de Azure se conecta con Claude a través de MCP. En ese caso, Claude –funcionando en el PC de un usuario– podría invocar herramientas expuestas por un agente alojado en Azure (como hacer una búsqueda web en tiempo real via Bing, o buscar en un índice interno de la empresa) y obtener la respuesta, todo mediante llamadas MCP seguras a Azure. Esto combina lo mejor de ambos mundos: los modelos avanzados de Anthropic consumiendo las capacidades y datos en vivo de Azure.

Desde la perspectiva del desarrollador en Azure Foundry, usar MCP implica unos pocos pasos: se configura/entrena el agente en Azure AI Agents, luego se habilita un servidor MCP que “enchufa” ese agente al exterior, y finalmente se conecta un cliente (sea una aplicación propia, un bot, o una herramienta de terceros) a ese endpoint MCP. Azure AI Agent Service, al ser totalmente gestionado, se encarga de la infraestructura, autenticación y escalado, por lo que el enfoque MCP encaja con facilidad: MCP actúa como lenguaje común para que los modelos utilicen agentes con acceso a conocimiento y herramientas. Microsoft indica que con Azure + MCP se pueden lograr capacidades como: consultas con fuentes web en vivo vía Bing, búsqueda en datos internos privados con Azure Cognitive Search, e incluso integrar otras fuentes como SharePoint o Microsoft Fabric, todo accesible para el modelo de forma unificada.

En pocas palabras, Azure AI Foundry utiliza MCP para conectar agentes de IA corporativos con modelos avanzados de manera estandarizada y segura. Esto abre la puerta a integrar asistentes de IA generales con los datos específicos de cada organización, sin que haya que desarrollar APIs dedicadas para cada caso. (Como apunte adicional: aunque el ejemplo dado es con Claude, cualquier cliente compatible con MCP puede aprovechar un servidor MCP de Azure; por ejemplo, un agente creado en Foundry podría ser consumido desde Copilot Studio u otros entornos que soporten MCP, dado el carácter abierto del protocolo).

Reflexión final: relevancia e impacto de MCP

Varias voces del sector lo comparan con la aparición de HTTP en los inicios de la web: así como HTTP estandarizó cómo se comunican los navegadores con los servidores web, MCP aspira a estandarizar cómo los modelos de IA interactúan con herramientas y fuentes de datos. Esta analogía no es exagerada si pensamos en los beneficios potenciales: con un protocolo común, los desarrolladores pueden conectar cualquier nueva aplicación o base de datos a cualquier asistente de IA sin esfuerzo artesanal, y los asistentes pueden “navegar” por las distintas fuentes de información de forma transparente, tal como hoy un navegador web puede acceder a cualquier sitio vía HTTP.

Dicho lo anterior, conviene matizar que MCP no pretende reemplazar protocolos universales existentes (no va a sustituir a HTTP, gRPC u otros), sino complementarlos añadiendo una capa de abstracción específica para contexto y acciones de IA. De hecho, MCP internamente se apoya en tecnologías web probadas (usa JSON-RPC sobre HTTP/HTTPS, SSE, etc.), pero definiendo mensajes semánticos adecuados al dominio de IA. Su impacto dependerá en gran medida de su adopción: hasta ahora, el apoyo de empresas como Anthropic y Microsoft, junto a una comunidad open source activa, apunta a un crecimiento acelerado. Ya existen decenas de servers MCP para servicios populares y varias herramientas cliente integrándolo, señal de un ecosistema en ebullición.

En perspectiva, MCP busca facilitar que las capacidades de los modelos de IA estén realmente al servicio de nuestras aplicaciones y datos cotidianos. Si logra consolidarse, podríamos ver un futuro próximo en el que conectar un nuevo sistema a nuestro asistente de IA sea tan sencillo y estándar como lo es hoy en día acceder a una página web. Sin proclamarlo como “vital” o “crítico” de forma exagerada, sí podemos reconocer a MCP como una evolución natural y muy prometedora para derribar las barreras entre la inteligencia artificial y el vasto universo de información y servicios que manejamos a diario. Un lenguaje común hombre-máquina-datos, abierto y universal, que bien empleado podrá multiplicar la utilidad y alcance de la IA en prácticamente cualquier ámbito, desde el desarrollo de software hasta el marketing, la educación o la gestión empresarial.

¡Si has llegado hasta aquí es que verdaderamente eres un amante de la IA!